清华第二代60亿参数ChatGLM2开源!中文榜居首,碾压GPT-4,推理提速42%

ChatGLM-6B 自从三月份问世之后,引起了 AI 社区的轰动,至今已在 GitHub 上收获了 29.8k 颗星。然而,现在第二代的 ChatGLM 已经悄然而至!清华大学知识工程与数据挖掘小组(THUDM)最近发布了一款中英双语对话模型——ChatGLM2-6B。

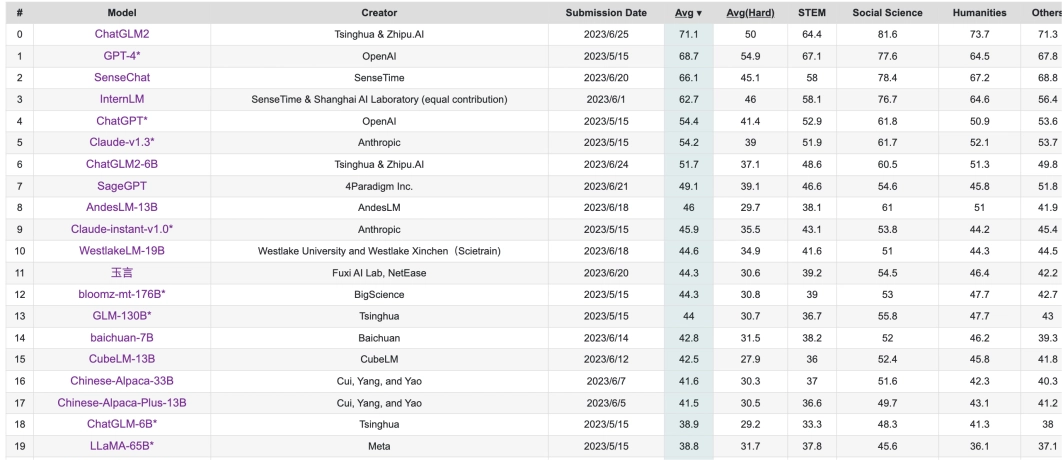

值得一提的是,在中文评估榜单 C-Eval 中,ChatGLM2 以突出的 71.1 分位居榜首,轻松超越 GPT-4。而最新版本的 ChatGLM2-6B 更是以 51.7 分的优异成绩登上了第六名的宝座。

ChatGLM-6B 的第二代版本,在继承了初代模型流畅对话和低门槛部署等许多优秀特性的基础上,引入了许多令人振奋的新特性:

1. 超强的性能

基于初代模型的开发经验,ChatGLM2-6B 的基座模型经过全面升级。ChatGLM2-6B 使用了混合目标函数的 GLM,经过了 1.4T 中英标识符的预训练并与人类偏好进行对齐训练。

评测结果表明,与初代模型相比,ChatGLM2-6B 在 MMLU(增长 23%)、 CEval(增长 33%)、 GSM8K(增长 571%)和 BBH(增长 60%)等数据集上取得了巨大的性能提升,在同尺寸的开源模型中具有强大的竞争力。

2. 更广泛的上下文

基于 FlashAttention 技术,研究人员将基座模型的上下文长度从 ChatGLM-6B 的 2K 扩展到了 32K,并且在对话阶段使用 8K 的上下文长度进行训练,使得更多轮的对话成为可能。然而,目前版本的 ChatGLM2-6B 对于单轮超长文档的理解能力还有限,这将在后续的迭代升级中进行重点优化。

3. 更高效的推理

基于 Multi-Query Attention 技术,ChatGLM2-6B 具有更高效的推理速度和更低的显存占用。在官方模型实现下,推理速度相比初代提升了 42%,在 INT4 量化下,可以支持的对话长度从 1K 提升到了 8K,仅使用了 6G 的显存。

4. 更开放的授权协议

ChatGLM2-6B 权重完全对学术研究开放,并允许商业使用,前提是获得官方的书面许可。

与初代模型相比,ChatGLM2-6B 在多个方面的能力都取得了巨大的提升。

与此同时,研究团队选取了部分中英文典型数据集进行评测并发布了 ChatGLM2-6B 模型在 MMLU(英文)、 C-Eval(中文)、 GSM8K(数学)、 BBH(英文) 上的测评结果。此外,该团队还对比了生成 2000 个字符的平均速度,其效果如下图所示:

清华大学发布了第二代规模达 60 亿参数的 ChatGLM2,该模型在中文领域表现出众,远超过了 GPT-4,推理速度提高了 42%。ChatGLM2-6B 采用 Multi-Query Attention 技术,极大地提升了生成速度,同时还有效降低了生成过程中 KV Cache 的显存占用。

除此之外,ChatGLM2-6B 采用了 Causal Mask 技术进行对话训练,使连续对话时能够重复利用之前轮次的 KV Cache,进一步优化了显存占用。

因此,使用 6GB 显存的显卡进行 INT4 量化的推理时,一代的 ChatGLM-6B 模型最多能够生成 1119 个字符就会提示显存耗尽,而 ChatGLM2-6B 能够至少生成 8192 个字符。研究团队还对量化对模型性能的影响进行了测试,结果显示量化对模型性能的影响在可接受范围内。

项目地址:https://github.com/ THUDM / ChatGLM2-6B

HuggingFace:https://huggingface.co/THUDM/chatglm2-6b